Institut Fredrik Bull

The corruption of the best things gives rise to the worst.

– David Hume

When forewarned you should be forearmed

1-Introduction

La pandémie du covid-19 qui a été active depuis le début de l’année 2020 a impacté nos vies personnelles, professionnelles et sociales de manière très concrète. Si la situation est devenue endémique par rapport à ce virus et ses variants, d’autres pandémies sous des formes variées apparaîtront et risquent de perturber en profondeur nos constructions sociétales comme l’expriment Xavier Emmanuelli et B. Cyrulnik dans leur ouvrage ‘Se reconstruire dans un monde meilleur’ (1) : ‘La pandémie est un minuscule problème biologique, mais un immense problème de civilisation’.

La désinformation qui s’est développée depuis une vingtaine d’années au moyen de ce qui est appelé les ‘réseaux sociaux’ a atteint une ampleur dont la prise de conscience est liée au fait que notre santé est concernée à court terme. Les informations utilisées par les autorités sanitaires se traduisent par des contraintes aux quelles nous sommes tous soumis (port du masque, confinement, vaccination) et des réalités factuelles (augmentation du nombre de décès). Certains contestent les décisions gouvernementales et s’appuient sur des données non contrôlables disséminées très rapidement par les ‘réseaux sociaux’ (efficacité des masques, utilité de la vaccination, nouveaux variants plus ou moins pathogènes.)

Dans cet article nous allons examiner sous l’angle de la désinformation ce qui se passe dans le domaine de la recherche universitaire en s’appuyant en particulier sur la recherche médicale, du comportement cognitif des individus soumis à des désinformations avec l’exemple de la guerre actuelle en Ukraine, et dans celui de l’écologie qui est entré dans l’arène politique avec des réactions manquant de rationalité et de bases de connaissances pertinentes.

2-Publications scientifiques biaisées : mise en perspective de la publication dans The Lancet d’un article sur la hydroxychloroquine

Dans sa livraison du 22 mai 2020 le journal médical de réputation mondiale The Lancet (2) a publié dans sa version en ligne, un article sur l’absence d’efficacité de la hydroxychloroquine dans le traitement des maladies causées par le covid 19, signé par quatre chercheurs du Bringam and Women’s hospital à Boston (MA). En dépit d’une procédure supposée de ‘peer reviewing’ des investigations post-publication ont montré que les sources de données utilisées étaient non fiables, en particulier de la part d’hôpitaux australiens qui n’avaient jamais fourni de données pour une telle étude. Il s’est avéré que les données provenaient d’une société Surgisphere, contrôlée par l’un des auteurs. Les trois autres signataires ont alors demandé à ce que leurs noms soient retirés de la publication alors que le quatrième a refusé de le faire.

Cette situation illustre l’hyper- compétitivité qui prévaut dans les communautés de recherche académiques, publiques ou privées. Il y a des enjeux financiers pour ces communautés pour obtenir des financements publics ou privés mais aussi des enjeux personnels pour le développement de carrière des chercheurs. Un autre aspect est la difficulté de trouver des reviewers fiables pour les raisons qui vont être explicitées par la suite.

2-1Brefs commentaires sur les théories et méthodes scientifiques dans les sciences de la santé

Le domaine des sciences de la santé au sens large est un domaine qui intéresse tout un chacun dans la mesure où la santé concerne tout le monde. On peut se demander pourquoi ce domaine est peut-être plus facilement l’objet de mensonges ou de demi-vérités. D’abord les enjeux économiques pour les ‘big pharmas’ sont très importants à l’échelle mondiale. D’autre part il y a des raisons intrinsèques à la nature même de la cible applicative des sciences de la santé et des méthodes scientifiques utilisées. Explicitons ces deux derniers points.

L’être humain est un système complexe de systèmes. Les interactions entre ces systèmes sont dynamiques, i.e. évoluent au cours du temps et sont spécifiques à chaque individu. Les résultats des recherches dans l’industrie pharmaceutique et dans les centres hospitaliers sont obtenus avec des techniques d’échantillonnage et publiés sous forme de probabilité. La probabilité 1(certitude) n’existe pas. D’ailleurs sur les notices accompagnant les médicaments les intolérances possibles sont indiquées en termes de probabilités.

Des ouvrages ont été publiés pour dénoncer les données cachées au public. Citons parmi d’autres, celui en français de Stéphane Foucart (3) dont le sous titre est explicite « Comment les industriels manipulent la science et nous mettent en danger ».

L’étude de l’évolution des théories scientifiques a amené certains auteurs comme Popper (4) à parler de ‘falsification’ des théories scientifiques. Explicitons cet aspect des théories scientifiques. Karl Popper établit une démarcation entre sciences sociales et politiques et sciences expérimentales. L’idée de falsification, i.e. de réfutation, par l’expérimentation est pour lui centrale pour caractériser le savoir scientifique. Toute science requiert à ses débuts, dans ses engagements ontologiques, des énoncés métaphysiques qui doivent être progressivement éliminés ou transformés en énoncés testables. Toutes les sciences reposent sur l’observation du monde. Celle-ci ne peut qu’être partielle mais mène à des lois générales. Les conditions contingentes dans les quelles elles sont appliquées ne garantit pas des conclusions justes. Plutôt que de parler de vérification d’une hypothèse ou d’une conjoncture comme le fait Henri Poincaré (5), Karl Popper parle de corroboration par des tests. La corroboration ne permet pas de conclure à la ‘vérité’ d’une hypothèse jusqu’à la fin des temps.

Dans le domaine de la santé humaine, la complexité est telle que la mise en œuvre de tests fait que les résultats laissent toujours un doute sur leur généralisation. Cette situation facilite les manœuvres d’acteurs mal intentionnés pour en tirer un profit calculé.

2-2Bref historique du peer reviewing avec l’objectif de publication

Le système de peer review apparut en Angleterre en 1665 avec la publication des Transactions of the Royal Society sous la houlette de son premier éditeur Henry Oldenburg (1618-1677). L’intention était que ‘’the honor of ye [author’s] invention will be inviolably preserved to all posterity” (Oldenburg, 24 November 1664). Il fut décidé que les articles soumis pour être publiés dans les ‘Society’s Philosophical Transactions’ devraient être examinés par des membres seniors de cette société avant d’être acceptés pour publication.

Le système est resté dans son essence le même depuis lors. Il a reçu des modifications bénéfiques mais a subi depuis quelques dizaines d’années des corruptions qui minent sa réputation et jettent un doute profond sur la qualité de l’information diffusée.

On estime qu’il existe aujourd’hui 30000 journaux avec peer reviewing, produisant deux millions d’articles annuellement. Les technologies ont favorisé le développement d’éditeurs (publishers) prédateurs qui inondent les chercheurs de toutes disciplines de mails ‘call for papers’ et font payer les auteurs pour que leurs articles soient acceptés sans être factuelle ment lus avant d’être publiés.

Le terme de ‘fake peer review’ est introduit dans un article du New York Times (6) par la journaliste Jennifer Schuessler dans lequel elle explique que James A. Lindsay, Helen Pluckrose et Peter Boghossian ont écrit vingt articles ‘bidon’ et que certains ont été acceptés et publiés dans des revues.

2-2-1 Difficultés rencontrées aujourd’hui par le peer reviewing

-*Il est de plus en plus en plus difficile de trouver des reviewers honnêtes, compétents et prêts à consacrer du temps à analyser en profondeur des textes qui leur sont soumis.

Par honnêtes, il faut comprendre l’absence de conflits d’intérêt académique ou financier avec le contenu du texte proposé à la publication. Il est reconnu que dans l’industrie pharmaceutique des publications sont produites directement, ou indirectement au travers de contrats de recherche avec des institutions académiques, pour ‘leurrer’ la concurrence sur la nature réelle des sujets étudiés en interne.

Par compétents il faut être conscient que la spécialisation fait que dans certains domaines le nombre de spécialistes est très limité, ou que l’absence partielle de connaissances- comme c’est le cas pour le covid 19- rend la convergence des avis virtuelle.

Enfin la course contre le temps dans un monde qui nous laisse peu de répits pour la réflexion personnelle, dialoguer avec des auteurs pour améliorer une publication ne rentre pas toujours dans le plan de carrière des spécialistes.

-*On assiste au développement de circuits de faux reviewers auxquels les ‘editorial boards’ des revues sont confrontés. Ceux-ci demandent parfois aux auteurs de suggérer des reviewers. Il apparait maintenant que ces reviewers sont faux ou vrais, mais appartiennent à un réseau de gens peu scrupuleux qui renvoient un avis favorable à l’adresse mail de celui qui requiert un avis.

Un exemple de collusion entre les auteurs d’articles et les reviewers a été dévoilé par Stéphane Foucart dans le journal Le Monde en date du 27 décembre 2008. Certains travaux des chercheurs de l’Institut de Physique du Globe de Paris (IPGP) étaient publiés dans la revue ‘Earth and Planetary Science Letters’ (EPSL) dont certains reviewers étaient à la fois membres de l’IPGP et du comité éditorial de la revue EPSL.

Il y a des officines qui proposent aux auteurs contre rétribution de prendre en charge tout le processus de peer reviewing. La pression dans certaines institutions est telle que les auteurs ou même les institutions sont prêts à payer pour publier et ainsi apparaître dans des classements de performance.

Pour faire face aux faux reviewers voici quelques types de contrôle mis en place par les ‘editorial boards’ :

-est-ce-que l’organisme d’affiliation du reviewer est crédible ?

-est-ce-que l’adresse mail du reviewer est celle d’un tiers ?

-y-a-t-il des conflits d’intérêt entre l’auteur et le reviewer ? appartenance à la même institution, habitude de co-publication

-est-ce-que le reviewer est un expert reconnu en regardant l’historique de ses publications sur des sites spécialisés ?

Ces opérations ont été automatisées par beaucoup de revues.

-*Un autre fléau est la manipulation des références citées par les auteurs, qui se manifeste sous deux formes. La première forme est celle où l’éditeur de la revue veut que les auteurs citent le maximum d’articles publiés dans leur revue afin d’améliorer son scoring dans le cadre de comparaisons entre différentes revues, phénomène constaté par divers observateurs du domaine.

Une seconde forme est la pression exercée par les reviewers pour que les auteurs citent leurs propres publications, quelles soient ou non pertinentes par rapport aux sujets traités, afin d’obtenir un avis favorable. Ce sujet a été en 2012 l’objet d’un forum organisé par le Committee on Publication Ethics (COPE) (7). La lecture approfondie des rapports des reviewers peut se révéler très instructive en faisant apparaître des positions excessives ou inappropriées.

2-2-2 Publish or perish

Ce slogan explique les initiatives très variées que l’on observe autour de la publication d’articles de recherche. Certaines ont pour objectif de tourner en dérision les procédés utilisés pour diffuser de l’information ‘scientifique’ en montrant comment il est facile, comme dans les réseaux dits ‘sociaux’, de fabriquer des ‘fake news’ et de devenir un influenceur rétribué au service d’intérêts privés ou politiques (fake news de Trump).

-Academia.edu est un site basé en Californie et fondé par Richard Price en septembre 2008.

C’est un anglais diplômé d’Oxford (UK) et détenteur d’un PhD en philosophie de la perception (2007). Le business model du site repose sur deux sources de revenus. Des universités (Oxford, Berkeley, MIT, University of New York(UNY) et des revues de recherche sont incitées à mettre sur le site d’Academia le contenu de leurs publications et les noms des auteurs, quand ils ont transféré leurs droits d’auteurs aux revues, ou à télécharger les références de leurs publications sur ce site. Contre paiement, dès qu’un auteur est mentionné dans un article chargé sur le site, il en est informé. Cette donnée lui permet d’évaluer sa réputation et son influence et de rentrer en contact avec le ou les auteurs de l’article où il est cité. Elle permet aux universités et aux revues de connaître leur réputation en comptabilisant le nombre de fois où ‘leurs’ auteurs sont mentionnés dans des publications de recherche.

Une seconde source de revenus est le conseil vendu à des institutions de recherche ou surtout d’enseignement supérieur sur les tendances observées sur les domaines de recherche. Les universités ainsi que des institutions d’enseignement supérieur dans les domaines de la gestion (écoles de commerce) ou de sciences sociales sont classées par des organismes privés (par exemple, Quacquarelli Symonds (QS), World University Ranking, Shanghai Ranking Consultancy, le Financial Times) sur la base de divers critères dont la ‘production’ de publications de recherche et le nombre de prix Nobel dans leur corps enseignant (sic !). Il est donc essentiel pour ces institutions de publier sur des sujets ‘tendance’ dans des revues à visibilité internationale.

-La première affaire de mise en lumière de publication d’articles ‘bidons’ est celle du physicien Alan Sokal de la NYU (8). En 1996 il soumit au journal bien connu ‘Social Text’ publié par l’Université Duke, un article farfelu qui mêlait la philosophie postmoderne et la gravité quantique (Transgresser les frontières : vers une herméneutique transformative de la gravitation quantique) . Il fut accepté et publié sans qu’un comité de lecture intervienne. Dès sa publication il révélera l’imposture intellectuelle dont la finalité était de montrer que les revues académiques pouvaient publier n’importe quel contenu, aussi farfelu soit-il.

Dans le même ordre d’idée, l’article publié récemment par neuf Suisses et Français sous des noms bien caractéristiques (Didier Lembrouille, Sylvano Trotinetta, Manis Javanica, Nemo Macron…) dans l’Asian Journal of Medecine (9) sous le titre « SARS-CoV2 was unexpectedly deadlier than Push-Scooters : Could Hydroxychloroquine be the Unique Solution ? » se veut une démonstration de la possibilité de publier n’importe quelle absurdité sous couvert de présentation ‘scientifique’.

-Dans la livraison du 14 Avril 2015 du MIT news, un article ‘How three MIT students fooled the world of scientific journals’ explique comment en 2005 trois étudiants (Jeremy Stibling PhD 2009, Dan Aguayo et Max Krohn PhD 2008) ont développé un programme informatique qui génère automatiquement des articles sur l’informatique (computer science) avec des graphiques, des figures et des citations qui sont réalistes.

Ce programme fonctionne comme une librairie folle (Mad Lib) en introduisant de manière aléatoire des mots clefs tels que ‘distributed hash tables’ et ‘Byzantine fault tolerance’. En 2005 ils réussirent à faire accepter l’article ‘Rooter : a Methodology for the Typical Unification of Access Points and Redundancy’ à une conférence World Multiconference on Systemics, Cybernetics and Informatics (WMSCI).

En 2015 Jeremy Stibling estimait que des articles étaient encore générés par ce programme.

-D’après le site Quartz Africa,(10) le gouvernement Sud Africain incite à participer à cette course effrénée à la production scientifique en offrant une subvention de US$7700 pour chaque article universitaire publié. Le nombre d’articles produits par la recherche sud africaine est passé de 4063 en 2005 à 10789 en 2014.

-En Suède a été créé le 1 janvier 2020 un conseil scientifique d’évaluation des malversations dans le domaine scientifique (NPOF) piloté par Peter Allebeck de l’Institut Karolinska à Stockholm. 46 dénonciations ont été reçues en 2020, ce qui parait beaucoup pour un pays de 10 millions d’habitants. 4 chercheurs ont été mis en cause.

Cette initiative fait suite au scandale de fraude scientifique dont a été l’auteur le chirurgien Paolo Macchianni. Il avait menti sur son CV, ne possédait pas d’autorisation des comités d’éthique scientifique et avait falsifié des données. Trois patients étaient décédés suite à des opérations qu’il avait effectuées.

2-3 Pour conclure

Selon l’enquête de la revue Nature en date du 6 septembre 2021, 8000 journaux ‘prédateurs’ publieraient 400 000 articles annuellement. Par ‘prédateurs’ il est signifié que ces journaux et revues tentent de se faire passer pour des publications respectables alors qu’elles ne font aucun travail éditorial de peer reviewing et réclament des frais exorbitants de publication.

C’est dans les domaines des sciences humaines que l’on trouve le plus de revues en ligne dont les titres ne semblent que répondre à des sujets ‘d’actualité’ tels que ‘Cogent Social Sciences’, ‘Gender Sciences’, ‘Sex Roles’….Les faibles coûts de lancement et de fonctionnement de sites en ligne poussent à la prolifération de ce genre de littérature.

La présence d’influenceurs auprès du personnel politique n’est pas nouvelle. Mais leur existence et leurs canaux d’action restaient moins visibles pour le grand public. On peut citer Tim Bell (1941+2019) qui fut le ‘spin doctor’ de Maragaret Thatcher et dont les actes sont qualifiés d’ignobles aujourd’hui. Il fut le conseiller en communication de différents dictateurs pour améliorer leur image publique.

Certains pensent que d’ici dix à vingt ans il ne sera plus possible de distinguer le vrai du faux sur les sites d’information ou de désinformation en ligne. Quels seront alors les canaux fiables de diffusion de l’information ? Y-aura-t-il un retour du papier pour assurer la dissémination transparente de données fiables dont l’origine est avérée ?

3.De la désinformation :de son élaboration à sa dissémination et à son impact

La crise sanitaire déclenchée par le covid 19 a servi de révélateur à un certain nombre de situations dont le grand public n’avait pas conscience, ou au mieux un sentiment diffus. Cela concerne essentiellement deux domaines, le domaine économique manufacturier et le domaine de l’information.

Au domaine économique manufacturier se rapportent toutes les importations de produits finis ou de matières premières qu’ils soient pour nous stratégiques comme les médicaments fabriqués en Inde ou non comme les masques venant de Chine.

Dans l’écosystème de l’information, les données sont devenues une ressource stratégique non seulement pour les entreprises mais aussi pour les citoyens qui sont amenés à prendre des décisions engageant leur avenir. La désinformation n’est pas une façon nouvelle d’influencer les pouvoirs publics, les gouvernements et les citoyens, mais elle a pris avec les réseaux sociaux une dimension et une importance inconnues jusqu’alors dans notre histoire humaine.

Dans cette section, nous présenterons dans une première partie le contenu résumé d’une émission diffusée sur la chaîne de télévision franco-allemande et intitulée ‘la fabrique de l’ignorance’ et dans une seconde partie l’impact de la désinformation sur la cognition humaine. Pour terminer nous donnerons quelques définitions de termes rencontrés dans l’écosystème de la désinformation.

3.1La fabrique de l’ignorance-agnotologie

Le 23 février 2021, la chaîne de télévision franco-allemande ARTE diffusait un programme ‘La fabrique de l’ignorance’.

Voici le texte de présentation de l’émission telle qu’elle était disponible sur le site www.arte.tv.

« Comment, des ravages du tabac au déni du changement climatique, on instrumentalise la science pour démentir… la science. Une vertigineuse investigation dans les trous noirs de la recherche et de l’information.

Pourquoi a-t-il fallu des décennies pour admettre officiellement que le tabac était dangereux pour la santé ? Comment expliquer qu’une part importante de la population croie toujours que les activités humaines sont sans conséquence sur le changement climatique ? Les pesticides néonicotinoïdes sont-ils vraiment responsables de la surmortalité des abeilles ? Pourquoi la reconnaissance du bisphénol A comme perturbateur endocrinien n’a-t-elle motivé que de timides interdictions ? Au travers de ces « cas d’école » qui, des laboratoires aux réseaux sociaux, résultent tous de batailles planifiées à coups de millions de dollars et d’euros, cette enquête à cheval entre l’Europe et les États-Unis dévoile les contours d’une offensive méconnue, pourtant lancée dès les années 1950, quand la recherche révèle que le tabac constitue un facteur de cancer et d’accidents cardiovasculaires. Pour contrer une vérité dérangeante, car susceptible d’entraîner une réglementation accrue au prix de lourdes pertes financières, l’industrie imagine alors en secret une forme particulière de désinformation, qui se généralise aujourd’hui : susciter, en finançant, entre autres, abondamment des études scientifiques concurrentes, un épais nuage de doute qui alimente les controverses et égare les opinions publiques.

Agnotologie

Cette instrumentalisation de la science à des fins mensongères a généré une nouvelle discipline de la recherche : l’agnotologie, littéralement, science de la « production d’ignorance ». Outre quelques-uns de ses représentants reconnus, dont l’historienne américaine des sciences Naomi Oreskes, cette investigation donne la parole à des acteurs de premier plan du combat entre « bonne » et « mauvaise » science, dont les passionnants « découvreurs » des méfaits du bisphénol A. Elle expose ainsi les mécanismes cachés qui contribuent à retarder, parfois de plusieurs décennies, des décisions vitales, comme le trucage des protocoles, voire la fabrication ad hoc de rats transgéniques pour garantir les résultats souhaités. Elle explique enfin, au plus près de la recherche, pourquoi nos sociétés dites « de l’information » s’accommodent si bien de l’inertie collective qui, dans le doute, favorise le ‘business as usual’ et la consommation sans frein. »

Dans ce programme, différents intervenants expliquaient comment un certain nombre de lobbies commerciaux, idéologiques et politico-sociaux interviennent de manière directe ou de façon masquée au travers de structures écrans, comme des groupes de réflexion, pour fabriquer de la ‘fausse science’ (mensonges, demi-vérités, contre-vérités) et la disséminer. Un de ces intervenants était le Pr Lewandosky de l’université de Bristol (Royaume-Uni). Ses propos sont inquiétants dans la mesure où il explique qu’il est très difficile de changer les convictions acquises des gens. Ils rejoignent la phrase attribuée à Voltaire : calomnier, calomnier, il en restera toujours quelque chose !

Peu de moyens, pour ne pas dire aucun dans certains cas, sont laissés à ceux qui sont exposés à des informations mises sur la ‘place publique’ pour pouvoir vérifier leur degré de véracité. Une véritable structure d’apprentissage de l’ignorance s’est mise en place grâce au développement des moyens techniques de communication dont l’usage échappe à tout contrôle dans les pays où la liberté d’expression est effectivement garantie.

Citons juste un exemple d’officine active dans le domaine du lobbying. Il s’agit du ‘Heartland Institute’ fondé en 1984 et basé à Arlington Heights (Illinois). En 2011 il employait 40 personnes à temps plein. Les actions qu’il déploie ont une orientation très conservatrice et couvrent un spectre très large de domaines (éducation, santé publique, sécurité sociale écologie). Son budget ainsi que l’origine des fonds reçus ne sont pas rendus publiques. On peut facilement imaginer que son budget se monte annuellement en millions de U$ dollars.

3.2 Désinformation et cognition

3.2.1 Mise en perspective du concept information

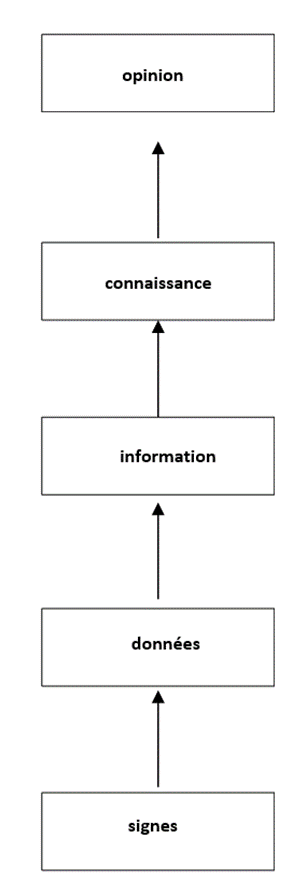

Il est important de définir un certain nombre de termes et d’examiner l’articulation des concepts sous-jacents à celui d’information. Les différents termes gravitant autour de l’information peuvent être présentés par une hiérarchie à cinq niveaux comme le montre la figure 1.

Figure 1 Articulation des notions de signe, donnée, information, connaissance et opinion

Commentons brièvement cette construction. A la base de la hiérarchie se trouve un ensemble de signes (par exemple alphanumériques). Pour que ces signes concaténés acquièrent le statut de données il faut les ordonner en faisant appel à un lexique morphologique et à une syntaxe qui permet de produire des signifiants. L’interprétation des signifiants conduit en fonction du contexte à des signifiés qui constituent de l’information. Celle-ci représente des données classées dans un rapport concret avec le contexte utilisé pour transformer les données en information. Lorsqu’une information particulière est ‘’interconnectée’’ avec d’autres informations, les relations ainsi constituées permettent de créer un réseau que l’on peut qualifier de connaissance. Des informations isolées n’offrent pas généralement la possibilité d’accéder à une compréhension d’une situation. A ces niveaux ‘objectifs’ vient s’ajouter une dimension subjective qu’est l’opinion qui conditionne le comportement humain. Elle résulte de deux facteurs, d’une part de la façon dont un individu va interconnecter les informations disponibles et d’autre part de la manière dont il va prendre des décisions sur la base de ces informations, de son expertise et de sa perception d’une situation contingente. Ces deux facteurs résultent non seulement de la génétique mais aussi des conditions psychiques de l’individu lors de l’apprentissage auquel il a été exposé et de la mise en œuvre de cet apprentissage sous forme d’expertise.

En dépit du fait que dans le langage courant information et données soient souvent employées de manière indifférenciée, ils représentent deux concepts à ne pas confondre. Les données sont des enregistrements de faits ou de connaissances objectivement observables et mesurables dans un domaine spécifique, de telle façon qu’ils puissent être transmis et mémorisés. L’information est la signification qu’une personne attribue à des données selon des conventions déterminées et en fonction de ses propres connaissances. La même donnée peut être perçue comme porteuse d’information différente selon le receveur.

Du point de vue d’un receveur de données ayant les connaissances requises pour les interpréter, ces données apportent de l’information dans la mesure où elles contribuent à réduire l’incertitude de la connaissance du receveur vis-à-vis de l’état d’un domaine physique ou mental concerné. Notre connaissance du monde, de notre environnement contient une part d’incertitude sur leurs états. C’est cette approche de quantification de l’information qui a été proposée par Claude Shannon dans son article de 1948 ‘’The Mathematical Theory of Communication’’ et qui s’exprime en terme de probabilités.

La perception de notre environnement se fait au travers de nos sens, vue, odorat, ouïe, toucher. La question qui se pose est : est-ce que la communication avec un environnement ‘virtuel’ au moyen de ce qui est convenu d’appeler une interface homme-machine est aussi effective que la communication face à face ?

Pour répondre à cette question il faut approfondir les relations existantes entre information et connaissance(s). Un terme qui est peu employé dans la littérature abondante relative à la connaissance et aux systèmes d’information est celui d’entendement. L’entendement est la faculté de comprendre au sens le plus général de ce mot: « the power of thinking is called the understanding and the power of volition is called the will » comme l’a écrit J. Locke. Il se différencie de la sensation et de la raison (Vernunft, Reason). I. Kant articule la connaissance de la façon suivante vis-à-vis des sens, de l’entendement et de la raison : « Alle unsere Erkenntniss hebt von den Sinnen an, geht von da zum Verstande, und endigt bei der Vernunft ».[1] La critique de la raison pure nous apprend qu’il faut distinguer les phénomènes perçus (Erscheinung), résultat des sens, et la chose en soi (Ding an sich) résultat d’un jugement.

Le fait de n’utiliser qu’une partie de nos sens pour percevoir un phénomène peut effectivement conduire à une apparence fallacieuse (Schein au sens kantien) dans la mesure où les apparitions sont confondues avec les choses en soi. La disparition de la frontière entre le réel et le virtuel dans ce qui est maintenant appelé le metaverse, doit contribuer selon toute vraisemblance à accentuer le nombre de cas de confusion.

L’entropie qui est utilisée pour mesurer le chaos, est interprétée comme l’incertitude sur la connaissance de l’état d’organisation des éléments d’un système. Ce terme signifie étymologiquement ‘’transformation interne’’ (έντροπειν).L’entendement pourrait être comparé à un mécanisme de ‘néguentropie’ au sens où l’a introduit L. Brillouin. Il permettrait de réduire le chaos existant dans les connexions qui doivent s’établir entre les informations mémorisées et les données transmises par les sens aux quelles un contenu informatif est attribué, pour faire émerger une forme de connaissance. L’entendement serait ainsi la transformation néguentropique des éléments mnésiques en connaissance. Cette hypothèse n’est pas en opposition avec le point de vue des neurosciences. En effet, dans le chapitre I du livre de Israël Rosenfield (11), y est expliqué le débat opposant les partisans de la localisation anatomique des fonctions du cerveau à ceux défendant une théorie holistique du cerveau ou une approche mettant l’accent sur l’importance du contexte et du sens perçu pour l’activité de remémoration. De la lecture de ce chapitre deux propositions ressortent :

- La mémoire associée au cerveau humain ne peut consister en traces mnésiques spécifiques organisées en une collection d’images que la fonction reconnaissance permettrait de comparer à celles d’objets nouvellement perçus ;

- La remémoration n’est pas indépendante de la situation dans laquelle le cerveau est sollicité pour produire un souvenir ; par contre elle dépend étroitement des circonstances affectives prévalant aussi bien au moment du processus de mémorisation lui-même que de celui de restitution du souvenir.

Si les traces mnésiques ne sont pas constituées en collections d’images statiques mais sont en interaction dynamique pilotée par une requête de remémoration en dépendance avec des émotions au sens de A.R. Damasio (12), il semble légitime d’estimer que une dépense d’énergie, sous forme de néguentropie, soit nécessaire afin d’assurer, sous une forme ou une autre les connexions appropriées entres les zones du cerveau concernées.

3.2.3Hystérésis des traces mnésiques

Une fois que nous avons reçu des informations qui ont été transformées en connaissance de quelque chose, il est difficile de l’éradiquer de nos mémoires. S’il s’agit de désinformation, la situation peut devenir critique.

Comme l’explique Stephan Landowski (13) la conviction dans l’existence d’ADM (Armes de Destruction Massive) iraquiennes est devenue si enracinée dans la conscience du public américain qu’en 2014 dix ans après la reconnaissance officielle de leur absence par le gouvernement américain, il s’est avéré que 51% des Républicains et 32% des Démocrates croyaient encore que des ADM avaient été découvertes en Irak.

Dans une étude menée durant les étapes initiales de l’invasion de l’Irak, S.Landowski et des collègues (14) ont présenté à des participants des nouvelles spécifiques sur la guerre, dont une partie a été par la suite corrigée. Ces participants ont été ensuite questionnés sur leur degré de croyance en ces nouvelles ainsi que leur mémorisation de l’information initiale et de leurs corrections. Nous avons découvert que de nombreux participants qui avaient la certitude que l’information avait été corrigée, croyaient aussi qu’elle était vraie.

Le comportement ‘Je sais que c’est faux mais j’ai la conviction que c’est vrai’ est la signature d’un effet associé à la cognition de la désinformation. L’effet peut être facilement généré en laboratoire quand aux participants sont présentés des textes entièrement fictifs mais plausibles au sujet d’événements divers. .

Il y a beaucoup de raisons pour lesquelles les gens ont des difficultés à rejeter l’information mémorisée quand elle s’avère fausse. Le facteur premier est que les gens se construisent un modèle mental de connaissance d’un récit à mesure qu’il se déploie. Une fois qu’un modèle a été construit, n’importe quelle correction qui identifie comme faux un de ses composants importants, peut ne pas être comprise parce que le retrait de ce composant créerait une rupture inexpliquée et un vide dans le modèle mental. En conséquence, il se peut que les gens puissent savoir très bien qu’un récit a été modifié quand ils sont interrogés, mais néanmoins ils peuvent continuer à faire confiance à la première explication reçue sur laquelle le modèle mental du récit a été construit. Pour qu’une correction ait des chances d’être comprise, il faut qu’elle soit accompagnée par une cause alternative explicative. Les gens sont capables de mettre à jour leur modèle mental en remplaçant un composant en cause par un autre à condition que l’explication du changement soit forte et cohérente.

3.2.4 Monde politique

La situation devient beaucoup plus délicate dans l’arène politique, quand la désinformation et les corrections impactent les convictions politiques profondément ancrées des gens. Dans ces circonstances, les corrections peuvent être particulièrement problématiques.

Un aspect important des corrections dans l’arène politique est relié à la ‘centralité’ de la désinformation par rapport aux comportements arrêtés des gens. Dans une récente étude Ullrich K.H. Ecker et Li Chang Ang (15) ont montré que les vues politiques des gens ne présentaient pas d’obstacle aux corrections quand le récit concernait un seul politicien qui était à l’origine suspecté de détournement avant d’être plus tard blanchi. Par contre quand le récit prétendait que tous les politiciens d’un parti particulier étaient enclins au détournement, une correction postérieure était fortement affectée par l’esprit partisan.

Dans ce cas si la désinformation n’était pas conforme au comportement (tous les politiciens de mon parti préféré sont corrompus), le retrait du mensonge était très effectif, et inversement si la désinformation était conforme au comportement (l’autre parti est corrompu) le retrait du mensonge était clairement ineffectif. Ainsi alors que les gens acceptent qu’un politicien particulier d’un parti ou d’un autre puisse ou ne puisse pas être corrompu, ils refusent d’accepter une condamnation globale de leur parti politique préféré, ce qui aurait requis un changement de leur comportement établi.

Stephan Landowsky et alii (16) ont mis à jour un variant de cet effet dans un article récent dans lequel on présentait aux électeurs américains des déclarations fausses faites par Donald Trump ou Bernie Sanders. Bien que les gens étaient réceptifs aux corrections – c’est-à-dire qu’ils croyaient moins aux faux énoncés après qu’ils aient été corrigés- les corrections avaient, au plus, un impact faible sur les sentiments des gens envers leur politicien préféré. Les supporters de Trump continuaient à supporter Donald Trump et ceux de Sanders continuaient à supporter Bernie Sanders. Ceci revient à dire que les gens se souviennent d’une correction, mais continue à faire confiance à l’information initiale.

3.2.5Pouvons-nous nous libérer de la désinformation ?

Dans quelques cas une cause alternative peut ne pas être disponible ou se révéler compliquée. Par exemple il est difficile de contrer, avec une cause alternative simple, la revendication de Donald Trump sur le fait que les vaccins sont la cause d’autisme. Une véritable alternative requiert au moins trois types d’arguments, à savoir une évidence irréfutable montrant l’absence de liens entre les vaccins et l’autisme, le fait que le lien prétendu provient de recherche frauduleuse et non éthique, et enfin le fait que le lien continue à être amplifié par des officines de media irresponsables longtemps après que le lien se soit avéré inexistant.

Une autre façon de combattre la désinformation est de l’empêcher de s’accrocher dès le départ. Si les gens peuvent être rendus conscients qu’ils puissent être induits en erreur, avant que la désinformation soit présentée, ils deviennent visiblement plus résilients à l’information biaisée. Ce processus est connu sous de noms variés, tels que ‘inoculation’ et se manifeste sous différentes formes. Au niveau le plus général, un avertissement frontal peut être suffisant pour réduire, mais non éliminer, par la suite la confiance en la désinformation.

Un variant plus complexe de l’inoculation non seulement fournit un avertissement explicite de la menace de désinformation, mais en plus il réfute un argument anticipé qui explicite le faux qui va se manifester de façon imminente. Par exemple, si les gens sont informés de l’arrivée d’une fausse expertise employée par l’industrie du tabac pour miner le consensus médical sur les risques sanitaires du tabac, à savoir des slogans publicitaires tels que « 20679 médecins disent que ‘les luckies sont moins irritantes’ », ces gens deviennent plus résilients par la suite à de la désinformation relative au changement climatique, qui utilise les mêmes techniques de fausse expertise.

La désinformation s’incruste et est difficile à déloger. Mais nous pouvons l’empêcher en premier lieu de s’accrocher en alertant les gens sur la façon dont ils peuvent être induits en erreur.

Dans certains cas la désinformation systématique fait partie d’une stratégie comme celle que Valeri Guerassimov, chef d’état major général des forces armées de la Fédération de Russie, a théorisée sous le nom de guerre hybride. Elle est appliquée depuis 2014 et consiste à préparer l’opinion publique à une guerre en utilisant des moyens informatiques, diplomatiques, économiques, culturels et psychologiques en plus des moyens militaires. Elle est utilisée par la Russie officielle depuis 2012 sous le nom de ‘propagande blanche’. Il s’agit d’augmenter les tensions et les divisions en particulier par une propagande numérique. On parle d’une sphère informationnelle (hardware, software et contenu) avec un contrôle d’accès à internet. La tactique est souvent de rester du seuil de déclenchement d’hostilités ouvertes en maintenant un caractère clandestin à ces activités. C’est une sorte de guerre par procuration. Est-ce une coïncidence si plusieurs ouvrages sur ces sujets ont été publiés récemment ?(17)

3.4 Quelques mots clarifiés

Beaucoup de termes sont utilisés aujourd’hui sans que le sens qui leur est donné par les interlocuteurs concernés soit partagé. Voici quelques définitions de termes rencontrés dans l’écologie de la désinformation :

- Mésinformation (misinformation) : fausse information disséminée sans intention d’induire en erreur. Une donnée reçue peut être comprise et interprétée différemment en fonction du récepteur qui lui attribue un certain sens et la transforme éventuellement en information selon un cadre de pensée contingent qui lui est propre ;

- Désinformation (disinformation) : mésinformation qui est disséminée intention-nellement pour induire en erreur ;

- Fake news : fausse information, souvent de nature sensationnelle, qui imite la forme et le contenu d’un media traditionnel ;

- Effet d’hystérésis de la désinformation (continued influence effect) : persistance de la confiance dans la désinformation après qu’une correction crédible ait été présentée. Il y a un effet de rémanence dans la mémoire des gens et dans leurs mécanismes de raisonnement ;

- Effet de vérité illusoire (illusory truth effect) : la répétitivité de la diffusion d’une information fait que celle-ci risque d’être jugée plus vraie qu’une nouvelle information. A force de répéter une contre-vérité, et encore plus une demi-vérité, les gens finissent par y croire. Le monde de la politique en est un exemple.

4 Changement climatique ou dérèglement climatique ? que sait-on de la situation objectivement ?

4.1 L’écologie : qu’est-ce que c’est ?

Quelques remarques sur les termes changement et dérèglement. Dans la littérature en langue anglaise le terme changement climatique (climate change) est généralement utilisé. Par contre dans la littérature francophone les deux expressions sont utilisées l’une pour l’autre.

Quand on utilise le terme dérèglement, cela devrait signifier ‘déviance des règles’. Quand il s’agit du climat de quelles règles s’agit-il ? Les grandeurs qui sont observées sont des ‘heuristiques’ dont les enregistrements fiables remontent à quelques centaines d’années au mieux. Des heuristiques sont ici dans ce cas des grandeurs prises en compte –et accessibles à la mesure- pour résoudre des problèmes à partir de connaissances incomplètes. La question qui se pose à propos de ces heuristiques est : quelles sont les variables ‘cachées’ qui permettent d’influencer effectivement les heuristiques observables ?

La mise en perspective de ce qu’est l’écologie est explicitée dans l’ouvrage de Jean Paul Deléage (18). La première société d’écologie a été créée en avril 1913 à Londres par des naturalistes britanniques la ‘British Ecological Society’, qui publie le ‘Journal of Ecology’. Au cours du temps, les études ont porté d’abord sur les végétaux, puis sur les insectes et les animaux et enfin sur leurs interactions avec l’homme. Au début des années vingt du vingtième siècle, l’écologie s’est surtout développée suivant deux axes de recherche, d’une part les rapports des êtres vivants avec leur environnement et d’autre part l’écologie de communautés vivantes. Alfred Lotka et Vito Volterra ont contribué à l’élaboration du modèle utilisé pour étudier les populations vivant en communauté, et en particulier les interactions de type prédateurs-proies. Ce modèle est un système d’équations intégro-différentielles.

Ces équations simplifiaient à l’extrême les situations écologiques réelles. Aujourd’hui les modèles utilisés se traduisent par des systèmes d’équations différentielles du premier ordre non linéaires, représentant des entités qualifiées de systèmes dynamiques qui sont en interaction. Le nombre des systèmes en interaction et la non-linéarité de leurs évolutions et de leurs interactions qui changent au cours du temps, est à l’origine d’une étonnante diversité des comportements calculés des modèles qui essaient de se rapprocher des réalités contingentes qu’ils prétendent décrire.

Henri Poincaré à la fin du XIXième siècle et au début du XXième siècle a étudié la mécanique du système solaire et a montré que les solutions de systèmes d’équations différentielles non linéaires sont dépendantes de manière critique des valeurs initiales choisies pour calculer des solutions numériques.

« Une cause très petite qui nous échappe, détermine un effet considérable que nous ne pouvons pas ne pas voir, et alors nous disons que cet effet est dû au hasard. Si nous connaissions exactement les lois de la nature et la situation de l’Univers à l’instant initial, nous pourrions prédire exactement la situation de ce même Univers à un instant ultérieur. Mais, alors même que les lois naturelles n’auraient plus de secret pour nous, nous ne pourrions connaître la situation initiale qu’approximativement. Si cela nous permet de prévoir la situation ultérieure avec la même approximation, c’est tout ce qu’il nous faut, nous disons que le phénomène a été prévu, qu’il est régi par des lois ; mais il n’est pas toujours ainsi, il peut arriver que de petites différences dans les conditions initiales en engendrent de très grandes dans les phénomènes finaux ; une petite erreur sur les premières produirait une erreur énorme sur les derniers. La prédiction devient impossible et nous avons le phénomène fortuit. » (19)

Nate Silver dans son ouvrage ‘The Signal and the Noise’, sous-titré ‘The Art and Science of Prediction’ (20) remarque que la prédiction qui se trouve à l’intersection de la réalité objective et de la réalité subjective, requiert à la fois des connaissances scientifiques et des auto-connaissances. Ses recherches l’ont conduit à constater que dans les publications académiques à partir du milieu des années 1950 le qualificatif ‘prévisible’ était devenu beaucoup plus fréquent que le qualificatif ‘imprévisible’ : 70% pour le premier contre 30% pour le second. Quelle est la signification de ce constat ? On pourrait penser que le déterminisme est devenu dominant par rapport au probabilisme dans l’évaluation des situations. L’analyse des raisons que l’on peut imaginer nombreuses sort du cadre de ce papier.

4.2 L’instrumentalisation de la biodiversité

Beaucoup de données et de faits sont encore inconnus ou mal connus à ce jour dans l’environnement où nous vivons et dont nous sommes une des parties prenantes. On parle constamment de biodiversité dans les média. En fait ce qui est présenté se limite à la flore et à la faune que nous percevons avec nos sens. Mais il existe au niveau du sol et du sous-sol des microbes qui ont des activités influençant ce que nous percevons, sans être conscients de leur existence et de leur impact effectif sur ‘notre’ flore et ‘notre’ faune.

Marc André Selosse, professeur au Museum national d’Histoire naturelle, dans deux ouvrages publiés récemment, ‘L’origine du monde’ et ‘Jamais seul’(21) nous fait découvrir ce monde que nous ne voyons pas et sur lequel nous marchons. Dans le premier ouvrage (p116) il écrit :’Dans 1 gramme de sol forestier sec de nos régions, il y a :

-100 000 à 10 millions de bactéries, appartenant à plusieurs milliers d’espèces différentes ;

-les filaments ou les spores de milliers d’espèces de champignons

-un millier d’amibes variées et de ciliés, d’une centaine d’espèces

– et de 10 à 100 millions de virus d’un nombre d’espèces…inconnu.’

Il affirme aussi que ‘l’écosystème terrestre est avant tout …le sol.’

William Ruddiman,(22) spécialiste américain des climats du passé, a émis une hypothèse surprenante : l’agriculture aurait changé le climat depuis longtemps. Il n’est pas question de discuter en détail ici cette conjoncture qui est encore en cours d’investigation. En quelques mots, le développement de l’agriculture, i.e. le travail des sols, aurait depuis des milliers d’années bien avant l’ère industrielle, favorisé la diffusion dans l’atmosphère de gaz carbonique et de méthane, gaz qui auraient perturbé les cycles astronomiques de Milankovitch. Ces cycles modulent l’exposition de la Terre au rayonnement solaire.

Des études sur l’évolution de la biodiversité des bactéries, virus, microbes commencent à être menées. Evan Palmer-Young du département d’Agriculture des USA et alii (23) a lancé une étude sur le développement apparent de transfert de parasites pathogènes d’insectes vers le monde animal. Whitney Stohr (24) insiste sur les interactions critiques entre les écosystèmes du sol et ceux du sous-sol. Ce qui est cultivé sur les sols interagit sur les sous-sols et inversement, ce qui peut déboucher sur des modifications importantes de la biomasse.

Beaucoup de questions restent en suspens :

-Des volcans redeviennent actifs comme aux Canaries : quel est leur impact sur la composition de l’atmosphère ?

-Chaque individu rejette entre 9 et 10 tonnes de dioxyde de carbone par an : que faire vis-à-vis des 8 milliards d’habitants de la planète ?

-On nous explique que les océans s’acidifient en absorbant le dioxyde de carbone atmosphérique : les volcans en activité au fond des océans jouent-ils un rôle sur la composition de l’eau des mers et océans ? Que deviennent le méthane atmosphérique et les autres gaz relâchés dans l’atmosphère tels que NH3 ? Y-a-t-il une modification significative observée des courants marins ?

Les rapports du GIEC qui font la une de la presse sont établis par des ‘spécialistes’ qui ne nous expliquent pas les hypothèses prises pour construire leurs modèles, les techniques probabilistes choisies (loi de Gauss ?), les incertitudes calculatoires liées aux lois de la physique mises en systèmes d’équations différentielles non linéaires.

Le climat et l’énergie sont les deux faces d’une même problématique. Pour éviter une approche parcellaire et donc partiale de cette problématique, seule une collaboration entre les spécialistes de ces deux disciplines permettrait des conclusions réalistes et cohérentes. Un exemple actuel est la désinformation officiellement diffusée sur la voiture électrique : moins de pollution atmosphérique locale, plus de pollution globale (production d’électricité et pertes en ligne, fabrication des batteries et traitement de leurs déchets).

L’industrie aéronautique travaille avec les pétroliers à la mise au point d’un nouveau carburant qui produirait moins de dioxyde de carbone mais plus d’eau. D’après certains spécialistes une augmentation de vapeur d’eau dans l’atmosphère à l’altitude de croisière des avions augmenterait l’effet de serre au niveau de la terre !

Prenons quelques exemples de prévisions qui ne se vérifient pas souvent.

*Marion Hubbert (1903+1989) est un géophysicien qui travailla au laboratoire de recherche Shell à Houston et occupa divers postes universitaires. Il prévu en 1956 que le pic de production de pétrole aux USA aurait lieu entre 1965 et 1970. En 1974 il estima qu’au niveau mondial le pic de production de pétrole aurait lieu en 1995. Il est connu pour sa ‘Hubbert curve’ et sa ‘Hubbert peak theory’.

*Le gouvernement britannique a lancé en 2020 un tournoi de prévisions, appelé Cosmic Bazaar, pour améliorer sa capacité d’analyse des renseignements. Il est demandé à des fonctionnaires, diplomates, espions et officiers de police de faire des prévisions à partir de données disponibles dans le domaine public. L’idée derrière cette initiative est le concept introduit en 1907 par le statisticien Francis Galton, de ‘sagesse des foules’. C’est une sorte de ‘gamification’ du traitement des renseignements par crowdsourcing des acteurs analystes.

Des travaux récents (Philip Tetlock- Université de Pensylvanie) ont montré que les experts ne produisent pas de meilleures prévisions que le hasard. Certes certains, appelés super-prévisionnistes, sont plus performants principalement parce qu’ils sont conscients des biais humains et de leur capacité à intégrer rapidement de nouvelles données. Beaucoup d’hommes politiques ont des ‘spin doctors’, ce qui ne les empêche pas de prendre de mauvaises décisions. Un seul exemple est la décision de D. Cameron d’organiser un referendum sur le Brexit.

*Comme l’explique Liv Grjebine (25) les épidémiologistes qui se sont trompés sur l’évolution de la pandémie covid 19 ont fait en sorte que la controverse scientifique soit court-circuitée au lieu d’être analysée, discutée, décortiquée : l’erreur est devenue persona non grata. Dans un article intitulé ‘Why doubt is essential to science’ (26) elle précise que ‘la science ne peut fournir des certitudes’ et que ‘le doute en science est un élément distinctif et non pas un bug’.

4.3 Pour conclure

Il ne s’agit pas de nier les constatations qui sont des faits avérés sur certaines grandeurs mesurées de notre environnement complexe. Alors que tout un chacun peut le vivre, les prévisions météorologiques basées sur la loi de Navier-Stockes caractérisée par une sensibilité critique aux valeurs initiales utilisées pour effectuer des calculs de simulation prévisionnelle, il semble difficile de faire confiance à des prévisions à dix, vingt ou trente ans, d’autant plus que nos connaissances sur le nombre, la nature des systèmes dynamiques concernés ainsi que leurs interactions dans lesquels nous vivons, sont encore partielles ou inexistantes. La presse parle de pratiques économiques ‘décarbonées’ : nous baignons dans un environnement constitué de composés du carbone, dont nous-mêmes.

L’incertitude étant une certitude, Suren Erkman, professeur honoraire d’écologie industrielle à l’Université de Lausanne se qualifie d’écolo-critique. Cette position lui permet d’exprimer des points de vue et de poser des questions aussi pertinentes que possible sans biais idéologiques. Dans une interview au journal suisse Le Temps daté du 2 septembre 2018, il déclare : ‘Il faut un esprit scientifique pour aborder le dossier climat….Il est nécessaire de prendre toutes les possibilités en considération y compris celles qui remettent les idées dominantes en question….Le véritable enjeu serait l’adaptation aux changements climatiques, et non l’atténuation de ces changements. Il était bien clair que tous ces projets de réduction de gaz à effet de serre allaient rester infinitésimaux par rapport à l’ampleur du problème.’

Comme l’explique Marc Lomazzi, auteur d’ultra ecologicus (27) « la marque de fabrique de l’écologie radicale, c’est un anticapitalisme virulent ». Il est difficile dans ce contexte d’examiner sereinement et objectivement ce que nous savons et ce que nous ignorons sur l’écosystème très complexe dans lequel nous sommes immergés. D’après lui existent deux écologies irréconciliables, une écologie axée sur la transition écologique et une écologie radicale qui prône la révolution verte et la décroissance.

Il faut éviter le fanatisme sur cette question où notre manque de connaissances est infiniment plus grand que les connaissances parcellaires actuellement disponibles, car comme l’a écrit Nietzche ‘le fanatisme est la seule forme de volonté accessible aux faibles’. Il faut découvrir les variables cachées derrière les grandeurs heuristiques qui sont mesurées pour espérer améliorer notre compréhension de notre écosystème.

5 Conclusion générale

La seule façon de faire en sorte que la désinformation ne ‘s’accroche pas ‘ est de développer la dissémination des connaissances ou l’absence de connaissances concernant un sujet donné. En particulier la notion d’incertitude doit être enseignée dès l’enseignement secondaire car elle est le tissu-même de notre écosystème physique, physiologique et social.

Un élément clef de ce challenge est la façon d’organiser des actions de formation et de les contrôler. La pandémie du covid 19 a montré de façon indiscutable l’aculture scientifique abyssale de la classe politique, essentiellement formée dans les mêmes officines (ENA, IEP). Dans le gouvernement actuel, la seule ministre ayant une formation scientifique est Elisabeth Borne (diplômée de l’Ecole Polytechnique). L’écrivain Alexis Jenni (agrégation des sciences de la vie et de la terre) précise dans une interview accordée au journal Le Figaro (28 février 2022) cet aspect : ‘La science apprend aux élèves à regarder le réel et à développer ensuite des raisonnements. Ces capacités de méthode et de discernement sont précieuses dans un environnement baigné d’informations. La France souffre d’un analphabétisme scientifique qui empêche d’avoir des avis éclairés.’

On peut se demander s’il ne faudrait pas créer des ministères du scepticisme de l’information, qui permettraient de présenter les opinions de vrais spécialistes, d’expliquer les incertitudes réelles, de démythifier le propos utopiques- pour ne pas dire les contre-vérités – avancés, sans argumentations réalistes- i.e. chiffrées- par la classe politique particulièrement au moment des élections.

Ce qui se passe aux Etats Unis –la plus grande démocratie du monde comme certains commentateurs politiques les caractérisent (ce qui est inexact puisque l’Inde est une démocratie) – en matière de manipulation politique, pousse certains à penser que le pays se dirige vers une seconde guerre civile après celle du dix-neuvième siècle. Il s’agit de Barbara Walter, professeur de sciences politiques à l’Université de Californie-San Diego, et auteure du livre ‘How Civil Wars Start’ (Viking) et de Shelton Bumgarner, éditeur du ‘The Trumplandia Report’.

Le conditionnement intellectuel dans nos démocraties ‘occidentales’ est aussi fort que dans les pays que nous appelons dictatoriaux. Deux films parmi d’autres exemples sont à comparer, d’une part le film de l’Américain Michael Moore ‘Fahrenheit 9/11’ (2004) et le film ‘Das Leben der Anderen’ réalisé par l’Allemand Florian Henck von Donnersmarck (2006).

Références

1-Xavier EMMANUELLI Boris CYRULNIK Se reconstruire dans un monde meilleur Humensciences (2021)

2- www.thelancet.com

Article publié le 22 mai 2020 puis retiré rapidement du site

3- Stéphane FOUCART La fabrique du mensonge-Comment les industriels manipulent la science et nous mettent en danger Denoel (2013)

4-Karl POPPER Logik der Forschung (1934)

Traduction française La logique de la découverte scientifique Payot (1973)

5-Henri POINCARE La science et l’hypothèse Flammarion Paris (1902) Chapitre IX

6- Jennifer SCHUESSLER New York Times (4 octobre 2018)

7 –Committee on Publication Ethics (COPE) https://publicationsethics.org forum 2012

8 -Alan SOKAL Transgressing the Boundaries. Towards a Transformative Hermeneutics of Quantum Gravity Social Text (Duke University) 46/47 pp 217-252 (1996)

9- Didier LEMBROUILLE, Sylvano TROTINETA, Manis JAVANICA,Nemo MACRON et alii SARS CoV2 was unexpectedly deadlier than Push-Scooters : could Hydroxychloroquine be the unique solution ? Asian Journal of Medecine 18 (2020)

10- www. quartz african

11 – Israël ROSENFIELD L’invention de la mémoire- Le cerveau nouvelles donnes Eshel Paris (1989)

12- Antonio R. DAMASIO L’erreur de Descartes Odile Jacob Paris 1995

13 – Stephan LEWANDOWSKY Disinformation and Human Cognition Security and Human Rights Monitor (13 août 2019) www.shrmonitor.org

14- Stephan LEWANDOWSKY, Werner G.K. STRITZKE, Klaus OBERAUER and Michael MORALES Memory for Fact, Fiction and Misinformation : The Irak War 2003 Review of the American Psychological Society Vol 16 N°3 pp190-195

15-Ullrich ECKER and Li CHANG ANG Political Attitudes and the Processing of Misinformation Corrections Political Psychology (ISSP) october 2018 pp241-260

16- Briory SWIRE-THOMSON, Ullrich K.H. ECKER, Stephan LEWANDOWSKY, Adam J. BERINSKY They might be a liar but they are my liar : source evaluation and the prevalence of misinformation Political Psychology (ISSP) october 2018 pp 241-260

17-D. COLON La manipulation de masse dans le monde contemporain Champ Flammarion Jean Sylvestre MARGRENIER Géopolitique de l’Europe PUF Que sais-je ? Paris (2020)

Le monde vu de Moscou –géopolitique de la Russie et de l’Eurasie prosoviétique PUF Paris (2020)

18- Jean Paul DELAGE Une histoire de l’écologie Editions de La Découverte Paris (1991)

19- Henri POINCARE Science et Méthode Flammarion Paris (1908)

20- Nate SILVER The Signal and the Noise The Art and Science of Prediction Penguin Books (2013) p453

21- Marc André SELOSSE L’origine du monde-une histoire naturelle du sol à l’intention de ceux qui le piétinent Actes Sud 2021

Jamais seul-ces microbes qui construisent les plantes, les animaux et les civilisations Babel Actes Sud 2017

22-William F. RUDDIMAN Earth’s Climate Past and Future W.H. Freeman 2000

23- Evan PALMER YOUNG, T.R. RAFFEL and Q.S. McFREDERICK Temperature-mediated inhibition of bumblebee parasite by an intestinal symbiont- Proceedings of the Royal Society B-biological sciences 31 october 2018

24- Whitney STOHR Below ground ecosystems- the foundation for forest health, restoration and sustainable management Journal of Environmental Assessment Policy and Management vol 15 N°4 Dec 2013 p 1-17

25- Liv GRJEBINE Le Figaro 21 avril 2021

26- Liv GRJEBINE ‘Why doubt is essential to science Scientific American october 9 2020

27-Marc LOMAZI ultra ecologicus – les nouveaux croisés de l’écologie Flammarion Paris(2022)

[1] Toute notre connaissance commence par les sens, d’où elle gagne l’entendement et s’achève dans la raison (B335)